Pourquoi NVIDIA domine-t-il le marché de l’IA ? Une nouvelle architecture ou des concurrents sont-ils nécessaires pour animer ce secteur en plein essor ? Les questions sont nombreuses dans une industrie qui est relativement nouvelle et qui a commencé à prendre forme il y a environ 10 ans. Sommes-nous peut-être face à un marché qui, comme les crypto-monnaies, laissera les utilisateurs sans cartes graphiques ?

NVIDIA et l’IA, ou comment y arriver en premier est un signe d’avantage clair

NVIDIA a été fondée en 1993 et fin 2010 avec seulement 17 ans d’existence et après être devenu un leader sur le marché des GPU, son PDG a eu une idée aussi géniale que peut-être absurde pour 99% des mondains : miser sur l’intelligence artificielle comme arme qui dominerait un nouveau secteur de données.

Huang était clair à ce sujet à ce moment-là, car il était clair pour lui que le nombre de données et leur complexité ainsi que leur poids augmenteraient de façon exponentielle et qu’il viendrait un moment où il serait impossible de donner un sens auxdites données. Aujourd’hui, même les gouvernements allouent de l’argent à l’apprentissage en profondeur, la Chine et les États-Unis étant à nouveau en première ligne.

Les analystes pensent que c’est le scénario où, après les semi-conducteurs, tout le monde sera en compétition pour analyser autant d’informations que possible et disposera d’algorithmes fonctionnant 24 heures sur 24 sans repos pour analyser tout type de menace ou de technologie future. Par conséquent, des puces de plus en plus nombreuses et plus rapides sont nécessaires, ce que Google a glissé en 2015 avec son projet d’IA, Amazon a déjà des puces d’inférence avec Alexa, même Baidu a Kunlum, où AMD a déménagé tardivement en achetant Xilinx pour l’accélération de l’IA dans le GPU, quelque chose similaire à ce qu’Intel a fait avec son Xeon en 2019 et se lance maintenant dans les ASIC et les GPU pour ce secteur et les jeux.

L’avenir des puces est d’avoir les meilleures pour l’IA

Dès lors, la guerre du futur sera d’avoir les meilleures puces pour l’intelligence artificielle et ainsi dominer le plus grand marché du monde dans à peine 20 ans. La question la plus évidente est de savoir pourquoi il va tellement croître et pourquoi des puces exponentiellement plus rapides sont nécessaires. La réponse, volume de données mis à part, est simple : les mathématiques. Les HPC effectuent des opérations mathématiques avec des simulations dites de haute précision, qui sont normalement de 64 bits (nous atteindrons 128 bits en peu de temps) et donc les processeurs sont nécessaires en raison de leur plus grande capacité à gérer des opérations aussi complexes.

Mais l’IA n’a pas besoin d’autant de complexité en termes de bits et des instructions 16 bits ou 8 bits peuvent être utilisées pour travailler les données, bien que les plus complexes continuent de tomber sur le CPU, un GPU accélère actuellement le simple chargement en plusieurs fois par rapport à un processeur, donc c’est complémentaire et tout dépend de logiciels comme TensorFlow de Google ou PyTorch de Facebook.

Pour cette raison, le secteur n’était pas ouvert à tout le monde, ce n’est pas seulement un processus où créer la meilleure puce vous donnera un avantage, et c’est là que NVIDIA se démarque également avec tout son arsenal de logiciels pour ses GPU. Ses bibliothèques logicielles font abstraction du programmeur et simplifient la manière de compiler le code afin qu’il n’interfère guère avec le GPU lui-même puisqu’il n’en a pas besoin.

Alors, à quel point sera-t-il important d’avoir la meilleure puce ? Il n’est pas nécessaire que ce soit un GPU, il peut s’agir d’un ASIC, d’un IPU ou d’un TPU spécifique, de n’importe quelle taille ou fonction tant qu’il est conçu pour l’apprentissage en profondeur. Et c’est que le logiciel tend à la centralisation, comme cela arrive avec les API ou le système d’exploitation et ici tout semble couler vers les options de Google et de NVIDIA lui-même, et donc la conception de puces pour l’IA est tout aussi importante que le logiciel ou famille de logiciels à utiliser.

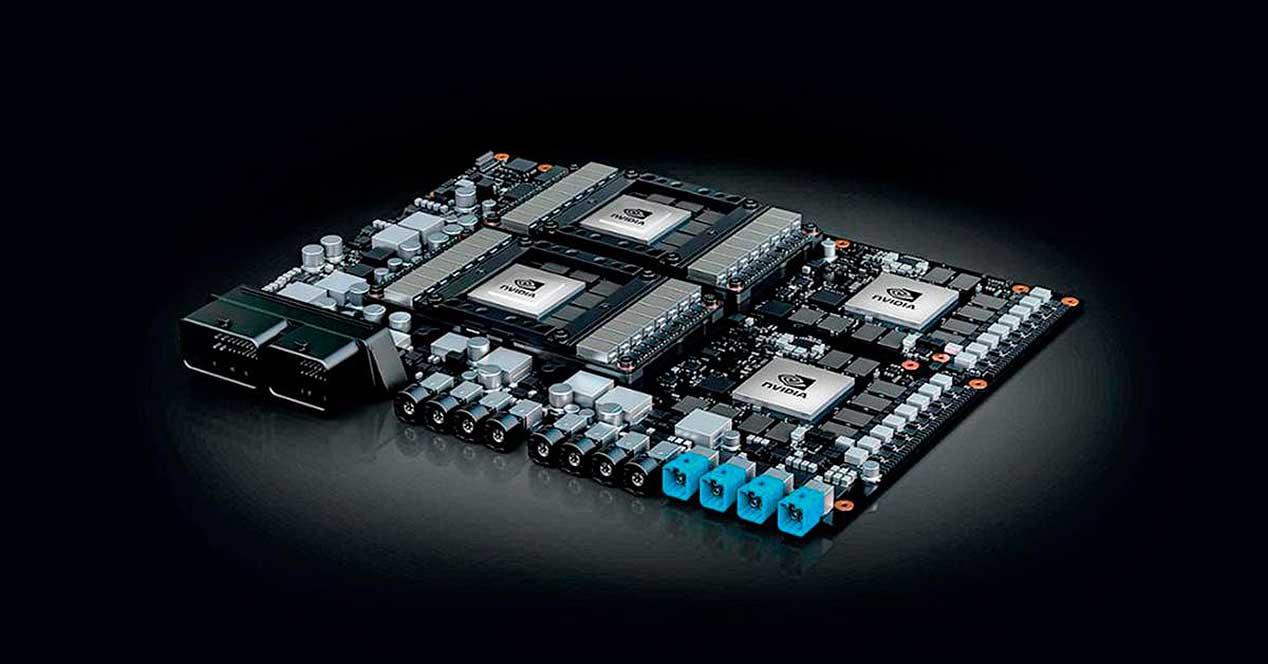

Le dernier mouvement dans ce secteur a beaucoup à dire, et ce n’est rien de plus que l’achat d’ARM par Huang’s, où s’il est terminé, nous pourrions parler de nouvelles puces signées par NVIDIA de faible consommation et de haute modularité qui sont spécifiques à l’IA et au DL , en particulier pour l’inférence, qui est la tâche la plus simple à faire et nous pouvons voir des GPU avec des SoC ARM sur le même PCB pour compléter diverses tâches, accélérant l’ensemble du système bien mieux que les options CPU + GPU + FPGA. Et c’est que l’inférence n’est normalement pas calculée au sein des serveurs Deep Learning actuels tels que DGX, mais est destinée à des serveurs externes plus petits.

Cette approche changerait tous les secteurs, puisqu’avec ARM et ses puces de NVIDIA on passerait à l’IoT, permettant de travailler non pas dans le cloud, mais sur l’appareil, par exemple. Par conséquent et en résumé, c’est un marché inexploité qui concevra le monde de l’information et avec lui tout ce qui s’y rapporte, façonnant le reste des appareils que nous utilisons quotidiennement, d’où l’importance d’avoir la puce la plus complète, le meilleur logiciel et la meilleure plate-forme pour AI et DL, un gâteau que beaucoup veulent, y compris les petites entreprises nées du mouvement de NVIDIA lui-même, les soi-disant « bâtards », qui se concentrent exclusivement sur ce marché.